Los centros de datos se han convertido en el centro neurálgico de la empresas. La nueva normalidad ha acelerado la necesidad de la transformación digital. Las empresas están poniendo al alcance de los clientes, vía internet, productos y servicios que antes solamente se obtenían en tiendas físicas. Esta transformación, de la mano del Internet de las Cosas (IoT), han permeado profundamente en nuestra vida. Hoy, la forma en la que tomamos decisiones, vendemos, producimos y hasta socializamos, tiene su base operativa en la información que enviamos y obtenemos de dos sitios principales. Estos sitios son los centros de datos empresariales tipo Edge y las aplicaciones y desarrollos en la nube.

Ante esta indudable realidad, las preocupaciones habituales de los CIO de las empresas y su staff de TI se hacen cada vez más presentes. Las siguientes dudas se vuelven constantes:

- ¿Poseo la infraestructura correcta para brindar estos servicios?

- ¿Existen vulnerabilidades en mis sistemas?

- ¿Estoy correctamente protegido contra ciberataques?

Para resolver estas preguntas, el planteamiento de una estrategia integral de análisis de riesgos y vulnerabilidades en los sistemas del centro de datos es indispensable. Se debe tener como punto de arranque la infraestructura física de misión critica que permite la operación de los servidores de procesamiento de información. Pensemos que un análisis de riesgos es una pirámide, donde la base la constituye la infraestructura física y la punta la ciberseguridad. No podemos tener un centro de datos altamente disponible y seguro, sin antes haber resuelto las vulnerabilidades en los sistemas de energía y enfriamiento que conforman esa base.

Necesidad de voltear a ver la infraestructura de misión crítica

La infraestructura física de los centros de datos no solo es fundamental para la operación de IT, sino que también representa costos significativos de CAPex y OPex. Debido a esto, los administradores que gestionan instalaciones con alta disponibilidad poseen plataformas de monitoreo digital que les permiten administrar los activos de infraestructura de manera local y remota. El monitoreo puede ser a través de un DCIM (data center infraestructure manager) o un RMS (Remote Monitoring System) obteniendo:

- Monitoreo en tiempo real.

- Reducción del downtime, el MTTR y los gastos operativos.

- Incremento en la eficiencia y disponibilidad del servicio.

Tradicionalmente el CIO no voltea a ver la infraestructura ni sus plataformas de monitoreo a menos que estas presenten algún tipo de problemática. Sin embargo, ante la dependencia creciente de los servicios digitales, ya no es viable enfocarse solamente en el procesamiento como una posible puerta a vulnerabilidades. Estas pueden encontrarse desde la base hasta la punta de la pirámide.

Pensemos que el cibercrimen es una industria que alcanzó los 2 trillones de USD en 2019; que la mayoría de los ciberataques son permitidos por los propios usuarios (muchas veces de forma inconsciente al dar click en un archivo o al abrir una página de internet); que el 88% de los ciberataques son exitosos y que solamente 21% de ellos fueron detectados a tiempo. Prevenir estos ataques causantes de robos y perdidas de información o el apagado total de los sistemas (downtime) requiere que las plataforma de monitoreo sean seguras y estén bajo vigilancia por un equipo dedicado al desarrollo y operación (DevOps team).

¿Cómo elegir la plataforma de monitoreo digital correcta?

La selección correcta de la plataforma de monitoreo de infraestructura permitirá al CIO y a su staff poseer la paz mental necesaria para poder enfocar sus esfuerzos en resolver las dudas del resto de la pirámide. A continuación, revisaremos las mejores prácticas de selección de plataformas, principalmente para aquellas basadas en la nube.

Mejores prácticas SDL a seguir

Antes de implementar una plataforma de monitoreo digital, es necesario evaluar las soluciones de los proveedores disponibles en tres aspectos principales: diseño, implementación y operación. Debemos conocer el proceso de desarrollo seguro del ciclo de vida (SDL) que describa cómo la plataforma fue diseñada e implementada.

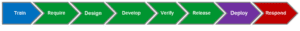

Originalmente propuesto por Microsoft, el proceso SDL permite considerar y evaluar la seguridad a lo largo del ciclo de vida de desarrollo de productos y soluciones. El uso de un proceso SDL para gobernar el desarrollo, la implementación y operación de una plataforma de monitoreo es una buena evidencia de que el proveedor está tomando las medidas adecuadas para garantizar la seguridad y el cumplimiento normativo.

La figura anterior muestra las 8 etapas principales a ser evaluadas en lo que respecta al desarrollo y funcionamiento de una plataforma de monitoreo remoto digital del centro de datos. A grandes rasgos, se debe contemplar lo siguiente:

- Entrenamiento continuo de los empleados para diseñar, desarrollar, probar e implementar soluciones seguras.

- Requerir y enumerar claramente las características de ciberseguridad a incluir en el desarrollo de la plataforma.

- Diseñar modelos de amenazas posibles para identificar, cuantificar y abordar los posibles riesgos de seguridad.

- Desarrollar procesos que incluyan análisis estático, binario y dinámico de los códigos usados.

- Verificar mediante pruebas de seguridad en la implementación de la plataforma, su desempeño desde la perspectiva de las amenazas, para asegurar su robustez.

- Durante el lanzamiento, es necesario poseer toda la documentación que defina como instalar, poner en marcha, mantener y gestionar la plataforma.

- Al implementar, el equipo de desarrollo debe estar disponible para proporcionar entrenamiento y asesoramiento técnicos sobre la mejores características de seguridad a instalar.

Por último, debe crearse un equipo de respuesta a ciber-emergencias que gestione las vulnerabilidades y soporte al usuario durante un ciber-incidente.

Aspectos clave una plataforma de monitoreo segura

A partir de las etapas SDL se pueden identificar tres aspectos clave que aseguren un buen nivel de ciberseguridad:

1-. Gente

La principal fuente de los ciberataques son personas dentro de las mismas organizaciones. Es por eso necesario identificar claramente quien desarrolla y opera la plataforma, con base en qué lineamientos son contratados, cómo fueron y son entrenados y qué nivel de acceso tienen a la plataforma y a la red (jerárquicamente hablando). Conocer esta información nos permite reducir la vulnerabilidad del sistema.

2-. Diseño de una arquitectura segura

La guía de diseño de la plataforma siempre deberá ser la ciberseguridad. La infraestructura del centro de datos puede ser altamente vulnerable y afectar de forma considerable la operación (downtime). Por ello es recomendable considerar, por ejemplo, poseer un Gateway como punto único de enlace de los equipos hacia la nube, usar HTTPS para proteger la confidencialidad e integridad de los datos, contar con autentificación multifactorial, encriptar la información sensible y poseer un código fuente seguro, entre otros.

3-. Pruebas de seguridad

Se deben realizar tests de seguridad que permitan probar la plataforma. Esto puede hacerse simulando un ataque, de la misma forma como lo haría un ciberdelincuente. Así se puede confirmar la robustez de la arquitectura y diseño de la misma. Se deben realizar pruebas desde las etapas de desarrollo del código de tal forma que se identifiquen y corrijan posibles debilidades desde el inicio.

El rol de los equipos DevOps

La vigilancia de post-implementación es muy importante. El proveedor debe poseer un equipo DevOps dedicado, que sea responsable de mantener la seguridad de la plataforma y reaccionar ante cualquier amenaza una vez que la plataforma sea implementada. Las funciones básicas de este equipo son tres:

- Detectar posibles amenazas realizando revisiones de forma continua.

- Reaccionar a cualquier problema crítico y estar disponible 24/7.

- Solucionar cualquier posible problema de seguridad e implementar acciones correctivas de manera fácil y segura en cualquier entorno.

Los equipos DevOps deben monitorear la seguridad todo el tiempo, de tal forma que la plataforma de monitoreo permanezca lo más aislada posible del exterior para asegurar su confiabilidad y su privacidad.

Finalmente, un elemento importante pero a menudo pasado por alto, es la responsabilidad del equipo de DevOps para detectar amenaza en la seguridad física. Por lo general, la seguridad física se considera competencia de los equipos dedicados a este fin que administran y monitorean el acceso al edificio. Sin embargo algunos aspectos de seguridad física requieren la gestión, o al menos la cooperación, entre el equipo de IT y el equipo de DevOps. Por ejemplo, el acceso de las personas al centro de datos y a los armarios de comunicaciones, así como a las áreas de desarrollo de software.

Protección contra ciberataques desde todos los frentes

Las plataformas de monitoreo digital modernas tienen el gran potencial de reducir el tiempo de inactividad, reducir el tiempo medio de recuperación (MTTR), facilitar los gastos generales de las operaciones y mejorar la eficiencia energética de la infraestructura de los centros de datos (sistemas de energía y refrigeración). Los motores de análisis de datos pueden proporcionar información valiosa sobre tendencias de comportamiento y operación importantes. Sin embargo, los sistemas de monitoreo conectados en línea podrían ser una vía potencial de ataque.

Mediante las prácticas de desarrollo, implementación y operación adecuadas, las plataformas de monitoreo digital con base en la nube pueden ser altamente seguras. Es importante tener discusiones profundas con los proveedores de monitoreo para comprender si estas prácticas se implementan, se siguen de forma adecuada y en qué medida. Este conocimiento ayudará a tomar decisiones más efectivas y brindará tranquilidad en la operación del centro de datos una vez implementado.

Conoce de la mano de los expertos en centros de datos y Cloud y Edge Computing los desafíos de esta era y como sobrellevarlos en Data Center Dynamics México Virtual. Regístrate aquí.

Añadir comentario